Snowpocalypse

В горах, куда я подумываю сходить, до четверга обещают 95 дюймов

снега (это примерно 2.5 метра). Вчера выписали предупреждение всем

кто находится в горах, брать ноги в руки и уматывать оттуда.

С практической точки зрения это означает что до того же четверга

дорога будет закрыта, и выдвигаться туда надо рассчитывать в пятницу,

что примерно соответствует моим логистическим ограниченям.

Но есть и хорошие новости -- эта волна снегопадов сопутствует

похолоданию, там приехал, судя по всему, arctic blast. Не то что

там будут лютые морозы, по предсказаниям NOAA там будет ниже

нуля круглые сутки, ну и на этом спасибо.

Если все перечисленное окажется правдой, что есть вопрос открытый,

то можно будет переждать безумие на выходных и двинуть туда в

понедельник. Тем временем, сижу и поглядываю на avalanche forecast,

2.5 метра за четыре дня это довольно некислый storm loading, при этом

в некоторые дни там обещают еще и ветер, следовательно надо будет

отслеживать еще и его направление. Маршруты, на которые мы замахиваемся,

почти не проходят под потенциально проблематичными склонами, но тут

ключевое слово "почти".

*потирает руки и лезет в карты местности*

Очень нужна помощь!

накарябал на питоне

import os, time

from pathlib import Path

DIR="cache"

CACHEPATH = Path(DIR)

TTL=12*3600 # 12 hours

if not os.path.exists(DIR):

os.mkdir(DIR)

def path(key: str) -> Path:

return CACHEPATH / key

def clear(key: str):

p = path(key)

if p.exists():

p.unlink()

def clearAll():

for p in list(CACHEPATH.iterdir()): p.unlink()

def isFresh(key: str) -> bool:

p = path(key)

if p.exists():

return time.time() < p.stat().st_mtime + TTL

else:

return False

def get(key: str) -> str:

if isFresh(key): return path(key).read_text(encoding='utf-8')

def put(key: str, value: str):

path(key).write_text(value)

def getOrCall(key: str, fun):

value = get(key)

if value == None:

value = fun(key)

put(key, value)

return value

if __name__ == "__main__":

# test the cache

TTL = 1

print("TESTING cache.py")

clearAll()

clear("non existent file")

testvalue = "--test contents\nof file 'test1'--"

put("test1", testvalue)

fromfile = get("test1")

assert fromfile == testvalue, f"Oops, bad input: {fromfile}"

clear("test1")

assert not os.path.exists("test"), "the file 'test' had to be deleted"

put("test2", "this file gets expired soon")

fromfile2a = get("test2")

assert fromfile2a == "this file gets expired soon", "Oops, bad file test2"

time.sleep(2)

fromfile2b = get("test2")

assert fromfile2b == None, "Oops, test2 still available?!"

value1 = getOrCall("test3", lambda key: f"<<{key}-1>>")

assert value1 == "<<test3-1>>", "first call of test3, got {value1}"

value2 = getOrCall("test3", lambda key: f"<<{key}-88>>")

assert value2 == "<<test3-1>>", f"second call of test3, got {value2}"

time.sleep(2)

value3 = getOrCall("test3", lambda key: f"<<{key}-3>>")

assert value3 == "<<test3-3>>", "third call of test3, got {value3}"

put("url/", "somedata")

fromfile4 = get("url/")

assert fromfile4 == "somedata", "problem with url/"

print("DONE TESTING cache.py")

(no subject)

даже и в его (неполном) собрании сочинений по квантмеху выпущенном АН СССР.

Не потому ли кота Шредингера скрывали от советских студентов?

Ну и по английски перевод заняло некоторое время отыскать, благо Perplexity пришел на помощь.

Это с моей стороны досадное упущение, надо будет почитать это всё.

The Promptware Kill Chain

Attacks against modern generative artificial intelligence (AI) large language models (LLMs) pose a real threat. Yet discussions around these attacks and their potential defenses are dangerously myopic. The dominant narrative focuses on “prompt injection,” a set of techniques to embed instructions into inputs to LLM intended to perform malicious activity. This term suggests a simple, singular vulnerability. This framing obscures a more complex and dangerous reality. Attacks on LLM-based systems have evolved into a distinct class of malware execution mechanisms, which we term “promptware.” In a new paper, we, the authors, propose a structured seven-step “promptware kill chain” to provide policymakers and security practitioners with the necessary vocabulary and framework to address the escalating AI threat landscape.

In our model, the promptware kill chain begins with Initial Access. This is where the malicious payload enters the AI system. This can happen directly, where an attacker types a malicious prompt into the LLM application, or, far more insidiously, through “indirect prompt injection.” In the indirect attack, the adversary embeds malicious instructions in content that the LLM retrieves (obtains in inference time), such as a web page, an email, or a shared document. As LLMs become multimodal (capable of processing various input types beyond text), this vector expands even further; malicious instructions can now be hidden inside an image or audio file, waiting to be processed by a vision-language model.

The fundamental issue lies in the architecture of LLMs themselves. Unlike traditional computing systems that strictly separate executable code from user data, LLMs process all input—whether it is a system command, a user’s email, or a retrieved document—as a single, undifferentiated sequence of tokens. There is no architectural boundary to enforce a distinction between trusted instructions and untrusted data. Consequently, a malicious instruction embedded in a seemingly harmless document is processed with the same authority as a system command.

But prompt injection is only the Initial Access step in a sophisticated, multistage operation that mirrors traditional malware campaigns such as Stuxnet or NotPetya.

Once the malicious instructions are inside material incorporated into the AI’s learning, the attack transitions to Privilege Escalation, often referred to as “jailbreaking.” In this phase, the attacker circumvents the safety training and policy guardrails that vendors such as OpenAI or Google have built into their models. Through techniques analogous to social engineering—convincing the model to adopt a persona that ignores rules—to sophisticated adversarial suffixes in the prompt or data, the promptware tricks the model into performing actions it would normally refuse. This is akin to an attacker escalating from a standard user account to administrator privileges in a traditional cyberattack; it unlocks the full capability of the underlying model for malicious use.

Following privilege escalation comes Reconnaissance. Here, the attack manipulates the LLM to reveal information about its assets, connected services, and capabilities. This allows the attack to advance autonomously down the kill chain without alerting the victim. Unlike reconnaissance in classical malware, which is performed typically before the initial access, promptware reconnaissance occurs after the initial access and jailbreaking components have already succeeded. Its effectiveness relies entirely on the victim model’s ability to reason over its context, and inadvertently turns that reasoning to the attacker’s advantage.

Fourth: the Persistence phase. A transient attack that disappears after one interaction with the LLM application is a nuisance; a persistent one compromises the LLM application for good. Through a variety of mechanisms, promptware embeds itself into the long-term memory of an AI agent or poisons the databases the agent relies on. For instance, a worm could infect a user’s email archive so that every time the AI summarizes past emails, the malicious code is re-executed.

The Command-and-Control (C2) stage relies on the established persistence and dynamic fetching of commands by the LLM application in inference time from the internet. While not strictly required to advance the kill chain, this stage enables the promptware to evolve from a static threat with fixed goals and scheme determined at injection time into a controllable trojan whose behavior can be modified by an attacker.

The sixth stage, Lateral Movement, is where the attack spreads from the initial victim to other users, devices, or systems. In the rush to give AI agents access to our emails, calendars, and enterprise platforms, we create highways for malware propagation. In a “self-replicating” attack, an infected email assistant is tricked into forwarding the malicious payload to all contacts, spreading the infection like a computer virus. In other cases, an attack might pivot from a calendar invite to controlling smart home devices or exfiltrating data from a connected web browser. The interconnectedness that makes these agents useful is precisely what makes them vulnerable to a cascading failure.

Finally, the kill chain concludes with Actions on Objective. The goal of promptware is not just to make a chatbot say something offensive; it is often to achieve tangible malicious outcomes through data exfiltration, financial fraud, or even physical world impact. There are examples of AI agents being manipulated into selling cars for a single dollar or transferring cryptocurrency to an attacker’s wallet. Most alarmingly, agents with coding capabilities can be tricked into executing arbitrary code, granting the attacker total control over the AI’s underlying system. The outcome of this stage determines the type of malware executed by promptware, including infostealer, spyware, and cryptostealer, among others.

The kill chain was already demonstrated. For example, in the research “Invitation Is All You Need,” attackers achieved initial access by embedding a malicious prompt in the title of a Google Calendar invitation. The prompt then leveraged an advanced technique known as delayed tool invocation to coerce the LLM into executing the injected instructions. Because the prompt was embedded in a Google Calendar artifact, it persisted in the long-term memory of the user’s workspace. Lateral movement occurred when the prompt instructed the Google Assistant to launch the Zoom application, and the final objective involved covertly livestreaming video of the unsuspecting user who had merely asked about their upcoming meetings. C2 and reconnaissance weren’t demonstrated in this attack.

Similarly, the “Here Comes the AI Worm” research demonstrated another end-to-end realization of the kill chain. In this case, initial access was achieved via a prompt injected into an email sent to the victim. The prompt employed a role-playing technique to compel the LLM to follow the attacker’s instructions. Since the prompt was embedded in an email, it likewise persisted in the long-term memory of the user’s workspace. The injected prompt instructed the LLM to replicate itself and exfiltrate sensitive user data, leading to off-device lateral movement when the email assistant was later asked to draft new emails. These emails, containing sensitive information, were subsequently sent by the user to additional recipients, resulting in the infection of new clients and a sublinear propagation of the attack. C2 and reconnaissance weren’t demonstrated in this attack.

The promptware kill chain gives us a framework for understanding these and similar attacks; the paper characterizes dozens of them. Prompt injection isn’t something we can fix in current LLM technology. Instead, we need an in-depth defensive strategy that assumes initial access will occur and focuses on breaking the chain at subsequent steps, including by limiting privilege escalation, constraining reconnaissance, preventing persistence, disrupting C2, and restricting the actions an agent is permitted to take. By understanding promptware as a complex, multistage malware campaign, we can shift from reactive patching to systematic risk management, securing the critical systems we are so eager to build.

This essay was written with Oleg Brodt, Elad Feldman and Ben Nassi, and originally appeared in Lawfare.

Рыбалка

Новый тип карго-культа

Так мы копируем самые эффективные методы новой сверхдержавы- Китая, которые и дали ей возможность стать сверхдержавой.

По следующим комментам, он возможно всерьез в это верит.

Фраза. Просто фраза

Кем бы ни был Пол Атридес. Он не напоминает мне ложного бога.

Он всегда стремился даровать людям обычную

хорошую жизнь.

ЗЫ придумал вариант как его надо переводить. Павел Атридич. А то сколько срачей, Поль он или Пауль...

Денег нет, но вы держитесь

Комитет Госдумы поддержал НДС на импортную продукцию на маркетплейсах

Здесь должен быть ролик из диснеевского "Робин Гуда", где принц Джон кричит "Удвоить налоги, утроить налоги!". Но гугль тщательно блюдет диснеевские копирайты и ни одного варианта видео не находит.

16 лютого, wikipedia

Литва: День Незалежності Литви

Україна: День військового журналіста

Події

1267 — Кастилія і Португалія уклали Бадахоський договір про міждержавний кордон.

1270 — литовці здобули важку перемогу над Лівонським орденом у битві при Карусе.

1659 — в Англії Ніколас Ванакер виписав перший у світі чек на 400 фунтів. Цей документ і досі зберігається в архіві Національного банку.

1918 — прийнято Акт про незалежність Литви.

1919 — почалася Вовчухівська операція УГА.

1923 — археологічна експедиція англійців, очолювана Говардом Картером, розкрила вхід до могильної камери фараона Тутанхамона.

1943 — радянські війська на місяць відбили у німців Харків.

1945 — експедиційні війська США почали операцію із захоплення Іодзіми. 21-тисячний японський контингент місяць стримував 100-тисячну армаду американців.

1985 — заснована ліванська шиїтська парамілітарна ісламістська організація Хезболла.

Народились 16 лютого

1813 — Семен Гулак-Артемовський, український оперний співак, композитор, драматург («Запорожець за Дунаєм»; пом. 1873).

1829 — Ізидор Шараневич, галицький історик, археолог і громадський діяч.

1877 — Микола Макаренко, археолог, музеєзнавець і мистецтвознавець.

1879 — Василь Королів-Старий, письменник і художник (пом. 1943).

1885 — Зінаїда Рибчинська, українська драматична акторка і співачка.

1905 — Петро Власюк, український агрохімік, ґрунтознавець і фізіолог рослин.

Померли

1391 — Іоанн V Палеолог, імператор Візантійської імперії.

1871 — Імам Шаміль, керівник національно-визвольної боротьби північно-кавказьких народів.

1885 — Руфін Судковський, український маляр-мариніст.

1892 — Генрі Волтер Бейтс, англійський натураліст і мандрівник, відкрив явище мімікрії.

1919 — Віра Холодна, видатна кіноакторка Російської імперії українського походження епохи німого кіно.

1968 — Олександр Хвостенко-Хвостов, український театральний декоратор, один з основоположників української сценографії.

1968 — Євген Маланюк, український письменник, сотник Армії УНР

1976 — Єлисавета Скоропадська, український скульптор, старша дочка гетьмана Павла Скоропадського.

1983 — Наталія Кандиба, українська акторка, майстер літературного читання і дублювання.

1992 — Олександр Оглоблин, український історик і археолог, один з творців державницького напрямку в українській історіографії.

2024 — Олексій Навальний, російський опозиційний політик, громадський діяч і юрист.

Film post: Death Race 2000 (1975)

Back to exploitation movies now, with this Roger Corman-produced (though Paul Bartel-directed) piece of futuristic dystopia. A just pre-superstardom Sylvester Stallone (Rocky was a year away) is the most recognisable name here, despite David Carradine taking top billing. In true Corman style, this was a quickfire and cheap (the budget was under $1m) response to Rollerball. There's an interesting satirical backdrop to the movie, even though Corman scrubbed many of the satirical jokes and leant more heavily into the cars and crashes once he realised that would play better at the box office.

The effects are pretty cheap – surprised? – and a lot of it doesn't actually make much sense. Why is one of the drivers a literal Nazi, complete with swastikas? Why doesn't "Mr President" have an actual name? Why is the scoring system apparently made up as the film goes along despite the race having taken place for years? But honestly, if you want a racing film that makes sense, go and watch Le Mans '66. This one is basically Wacky Races with added (cheerfully unrealistic) gore and bonkers TV reporters. If you ever played Carmageddon way back when, this film is why that exists. ★★½

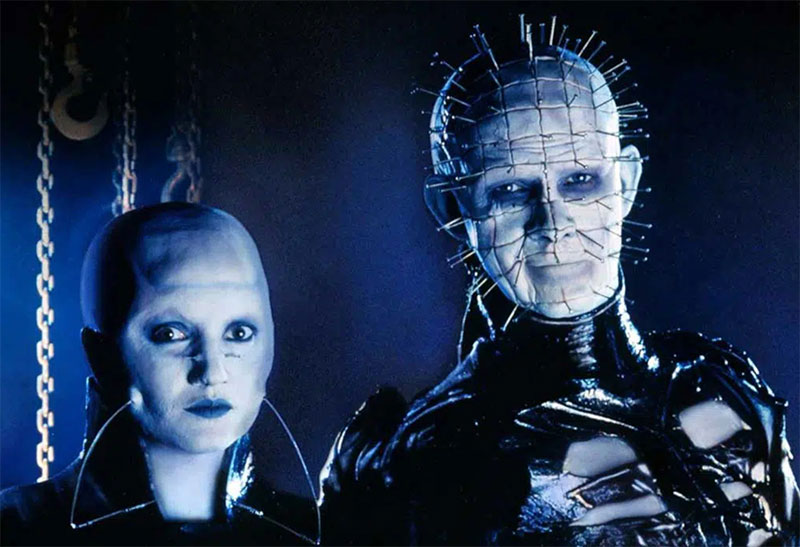

В гостях у сенобита

Товарищ Жуков (слово товарищ употреблено мною тут совершенно осознанно, Клим — коммунизд) тут разразился гневной статьёй про то, что, мол, гости гражданина Эпштейна — это сенобиты. Сенобиты, если вдруг кто забыл, — это граждане из франшизы Hellraiser.

Жуков, как обычно, свёл всё к копетализьму — мол, когда капиталистам выпендриться больше нечем, они начинают выпендриваться покупкой людей.

Исторические наблюдения, правда, показывают, что с секс-гаремами и в СССР был полный порядок. Лаврентий Палыч не даст соврать. И если рассказы о том, что конкретно Берия делал (и с кем), можно объявить враками, то протоколы обыска, где фигурируют подарки в виде интимной женской одежды заграничного производства (включая детские (!) размеры), а также некий «набор мужчины-развратника» (что бы это ни означало), — это уже факты. У Ягоды, к слову, помимо детской одежды и игрушек нашли ещё и порнографию вместе с резиновым членом.

Но поговорить мне хотелось не о детских гаремах мужчин, власть предержащих. Такое, увы, было (и будет) всегда. Да, с этим надо бороться, и дело тут, увы, далеко не в общественной формации.

Поговорить мне хотелось о сенобитах.

Во-первых, примерно 95% людей, смотревших Hellraiser, как водится, нихрена в нём не поняли.

Сенобиты — это не от слов «сено» и «биты» (которые восемь бит — один байт). Это, вообще-то, «киновиты» — монахи, проживающие в киновии, монашеской коммуне. Представители религиозного ордена. Просто орден этот в фильме… мягко говоря, не христианский.

У Баркера они не демоны, не бесы, не «монстры с крюками». Они — орден. С собственной теологией, собственной дисциплиной, и собственной философией боли.

Во-вторых, Клайв Баркер — это не простой английский слесарь, а гражданин довольно специфических интересов.

Клайв — гомосексуалист, в молодости работал в эскорт-услугах. Он был глубоко вовлечён в культуру садомазохизма и часто посещал BDSM-клубы, с завсегдатаев которых, собственно, и срисовал своих сенобитов.

А про что, вы думали, были все эти цепи, крюки, кожаные шмотки? Для красоты? Нет, конечно, это всё красиво — если вам нравится кожаная субкультура, зачастую связанная с садомазохизмом. Поищите в интернетах фразу leather daddy (только, умоляю, не на работе и не в присутствии детей) — найдёте там столько «сенобитов», сколько сможете унести ;-) Ну, и альбомы финского Тома могу ещё порекомендовать.

К участию в BDSM приходят, когда желают испытать наслаждение, граничащее с болью. И приходят добровольно. Сенобиты у Баркера не развращают — они отвечают на зов. Они приходят к тем, кто сам открыл коробку.

И тут есть один важный момент.

Посетители Эпштейна — это не сенобиты. Отнюдь.

Сенобиты не охотятся на детей. Они не ломают чужую волю. Они работают только с теми, кто сам ищет крайности.

Это Эпштейн — самый главный сенобит. Это к нему приходили «за наслаждением». Добровольно. По собственному желанию. А вот те, кого он втягивал в эту историю при помощи той же Гислейн Максуэлл, — никакой коробки не открывали.

В реальной жизни, когда любой сексуальный контакт переходит рамки согласия, граждане отправляются в тюрьму — как это и должно быть. И посетители «сенобита» Эпштейна, если они действительно всем этим занимались (что ещё должно быть доказано в суде — одного «общественного порицания» тут недостаточно), должны отправиться именно туда.

Потому что дело тут не в капитализме.

И не в коммунизме.

И даже не в коже, цепях, и эстетике боли — в конце концов, кто я такая, чтобы указывать взрослым людям, что они могут делать со своим телом.

Это вообще не вопрос идеологии.

Вопрос — в согласии.

P.S. С доказательной базой в подобных делах всё, как правило, печально. Одних дневников и слухов для приговора недостаточно — суд требует доказательств, а не общественного возмущения. И это правильно, как бы ни хотелось иногда обратного. Презумпция невиновности существует не для удобства преступников, а для защиты невиновных. Это принцип, который не стоит разрушать даже в самых отвратительных делах.

peposo

( Read more... )

вопрос про автомойку

"Мне нужно помыть машину. До ближайшей автомойки 50 метров. Лучше туда пойти пешком или поехать?"

или по-английски: "I want to wash my car. The car wash is 50 meters away. Should I walk or drive?"

Так вот, базовые модели: Grok 4.1 Fast, Claude 4.5 Sonnet, ChatGPT 5.2 Instant все отвечают, что конечно надо идти пешком, нет смысла ради 50 метров садиться, заводить машину итд. Только если сильный дождь, добавила одна из них. А "думающие" версии тех же моделей: Grok 4.1 Expert, Claude 4.6 Opus, ChatGPT 5.2 Thinking - все понимают, что без машины на мойке делать нечего.

И только Gemini уже в "быстрой" версии все равно сразу правильно говорит.

Разница между базовыми и думающими версиями довольно-таки значительна, не только для сложной математики.

P.S. Если вы будете пробовать то же самое, учтите, что в некоторых случаях "базовые" модели могут правильно сказать, зависит от языка вопроса, точной формулировки, включили ли вы режим инкогнито (я всегда включал) итд., включая просто случай. В моих проверках из пяти раз (английский язык, инкогнито) большинство ответов "базовых" моделей Grok/Claude/ChatGPT было неверным, а ответы "думающих" всегда верными.

16-Е /// Когда в крик.

И появляется у меня такое нехорошее подозрение (опять!), что эти самые "религиозные фанатики" ни во что не верят на самом деле. Отсюда такая агрессивность. "Вера" их построена на песке и любое сомнение способно сильно её, эту самую "веру", если не окончательно обрушить, то сильно поколебать. Проводник, который сам не уверен в себе, очень боится любого сомневающегося в его миссии, того, кто в открытую, вслух выражает своё недоверие и сомнения - потому, что сам вожак прекрасно знает, что заблудился и давно, но признаться в этом не хочет и не может. Поэтому будет очень агрессивно нападать на любого, кто выразит хоть каплю сомнения в том, что он, вожак, ведёт всех туда, куда следует. Глухой танцор будет педантичен и предельно точен, повторяя все па и движения танца и возмущаться в случае любого отклонения кем либо от затверженного порядка действий. При этом не испытывая и капли радости от самого танца, забудет о сути, зачем и для чего он это делает. Смысл, суть уйдёт - останется только следование ритуалам. Вера без сомнений не бывает - когда это вера. А когда веры нет - любое сомнение может разрушить всё. Отсюда и агрессия, порождённая страхом перед собственным безверием. Лучше честный атеист, чем злобное существо, которое страшно боится, что его в итоге разоблачат, что все поймут - этот человек на самом деле ни во что не верит, его душа пуста.

Одиннадцатая Заповедь Эйнштейна "Не бойся!" отлично подходит для живописи. Да, один, единственный мазок способен испортить картину, но он же может превратить её в шедевр. Приходится рисковать. В одном хорошем фильме это звучит, как метафора - одним своим поступком ты можешь изменить свою жизнь к лучшему. Или к худшему. Но выбора нет - приходиться идти на риск.

Пора, батюшка, — ответил швейцар, радостно улыбаясь, — в наш советский колумбарий

Былое и думы

Буквально пару дней назад натолкнулся у ТолиЭто была пре-пре-амбула. Преамбула состоит в том, что недавно ушёл в лучший мир мой старший коллега и друг, очень непростой человек Цвика Артштейн. Это благодаря ему я осёл там, где осёл. ( Преамбула )

И вот со временем пришла пора платить долги своим научным родителям и благодетелям (у меня есть отдельный тэг, мои учителя). После смерти Цвики оргкомитет из нескольких его ближайших коллег озаботился изданием мемориального сборника статей, посвящённого его памяти, и они спросили меня, не хочу ли я заплатить контрибуцию. The buck stops here, сказал я себе и пообещал организаторам представить статью по стационарной оптимизации на бесконечном интервале времени. В основном имея в виду написать дайджест собственных работ 40-летней давности с акцентом на открытые вопросы, которые нам тогда были не по зубам, и завернуть их в привлекательную обёртку, которая могла бы стимулировать интерес к ним спустя столько лет, — почему эти задачи вообще кому-то могут быть интересны сегодня.

Для начала надо было проверить, может, человечество в этом месте чего-то успело сделать и без меня: цитаты на мои работы потихоньку капали, хоть и не с той стороны, с которой мне было бы интересно. Но для очистки совести я решил поспрошать И.И. Перплешу, что ему известно про свершения в этой области. Чтоб не нарваться на поток безудержной лести (большинство ИИ норовят отвесить комплименты собеседнику), я сначала в режиме инкогнито постарался очертить тот кусок науки, который меня интересовал. Без ложной гордости скажу, что после трёх-четырёх промптов, сужающих круг задач без упоминания имён, Перплеша сам нашёл мои тогдашние сочинения. Предсказуемым образом, в нужную мне сторону никто всерьёз не думал. Тогда уж я разоблачился перед ИИ, загрузил его полудюжиной своих старых статей и ещё примерно таким же количеством релевантных статей классиков, и начал ему на пальцах объяснять, чего я не знаю и что бы хотел сформулировать как sexy problem.

( Амбула: ИИ приходит на помощь )

Честно говоря, я в шоке. Конечно, надо всё ещё сто раз перепроверить. Но вроде бы в отличие от пиздуна Гроши, Перплеша не был пойман на заведомом вранье, и всё, что он мне отвечал, выглядело исключительно правдоподобно.

За счёт чего так всё случилось? Нет, никаких новых идей Перплеша мне не предложил (в общем, неоткуда было: всю узкоспециальную литературу, которую я ему подсунул, я либо читал, либо вообще сам писал, хотя много чего перезабыл). Но он сэкономил мне бесконечно много времени, проделывая (символьные) преобразования и мгновенно проверяя (или опровергая) мои гипотезы про результат этих преобразований. И второе, конечно, тоже совершенно неоценимое качество, — Перплеша мгновенно находит в математических монографиях теоремы, которые я помню лишь приблизительно, и совершенно не помню, где я их мог читать. Грубо говоря, за 30 секунд он делает то, на что мне когда-то потребовался бы день в библиотеке с немедленным доступом к книжным полкам, а сегодня — несколько часов поиска гуглем или по разным Матсцынетам с неизбежной затратой времени на то, чтобы надыбать где-то полный текст пиратской копии книжки 50-летней давности.

Я никогда в жизни не играл в гольф, но немедленная ассоциация напрашивается. Перплеша — та самая таратайка, на которой ездят по полю для гольфа вместо того, чтобы потеть, бегая по нему с клюшкой от лунки к лунке. Более того, шарик ещё не успел упасть на землю после прошлого удара, а таратайка уже вычислила, где он приземлится, и готова везти хозяина туда немедленно для следующего удара.